爱站SEO工具包如何使用robots制作工具?robots制作工具方法介绍

时间:2023-03-19 03:20:03

编辑:花泽香菇

今天介绍,相信通过了解,大家对爱站SEO工具包这款软件一定会有更多的了解的!

“Robots”经常被一些同行朋友称作“萝卜丝”,是搜索引擎“网络爬虫排除协议”。通过Robots协议我们可以告诉搜索引擎,网站哪些页面允许抓取,哪些不允许。

如果你想禁止爬虫抓取网站某些目录,却又不熟悉robots文件的编写,你可以通过爱站seo工具包的robots制作工具,简单设置即可生成robots.txt文件。

如图,我们可以通过简单的选择和设置,生成robots.txt,并放在网站根目录下面,即可告诉搜索引擎爬虫哪些哪些页面可以抓取,哪些页面不能够抓取。

爱站SEO工具包相关攻略推荐:

爱站SEO工具包怎么使用网站日志分析工具?网站日志分析工具介绍一览

爱站SEO工具包能用robots检测功能吗?robots检测功能操作步骤

爱站SEO工具包如何使用HTTP状态功能?使用HTTP状态的方法一览

爱站SEO工具包怎么使用URL编码解码?使用URL编码解码的步骤分享

怎么样花泽香菇为大家带来的最新资讯是不是对游戏很有帮助?想了解更多精彩内容和最新资讯请持续关注ai7手游帮。

相关推荐

更多-

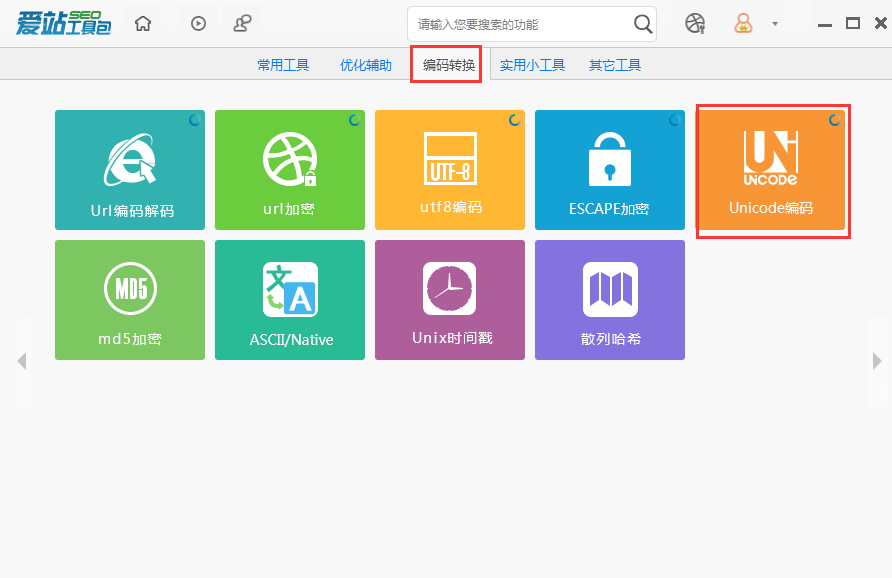

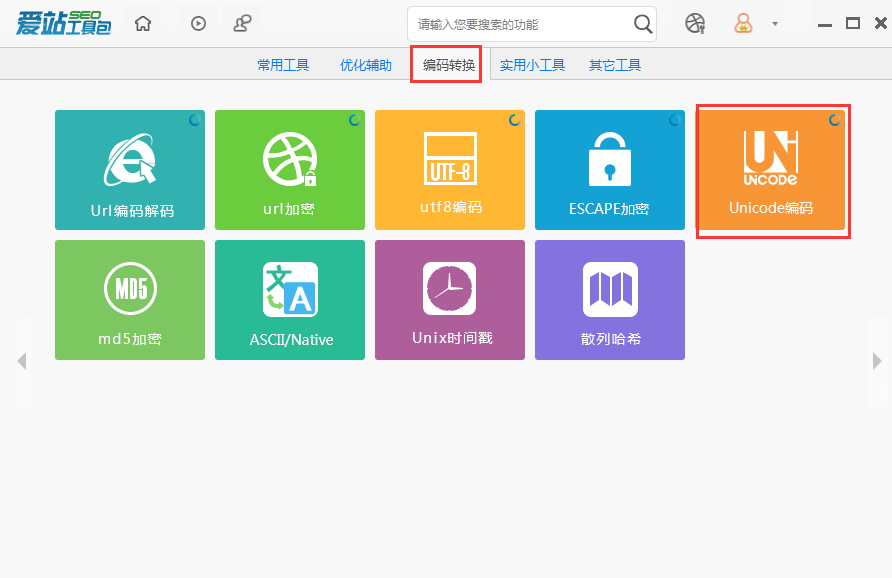

爱站SEO工具包编码功能怎么使用_Unicode编码功能的使用步骤

2023-03-24

-

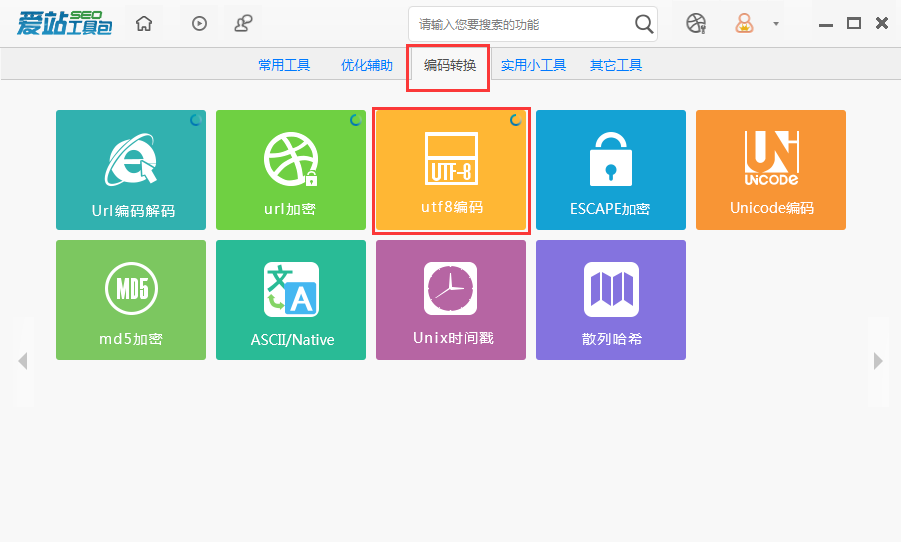

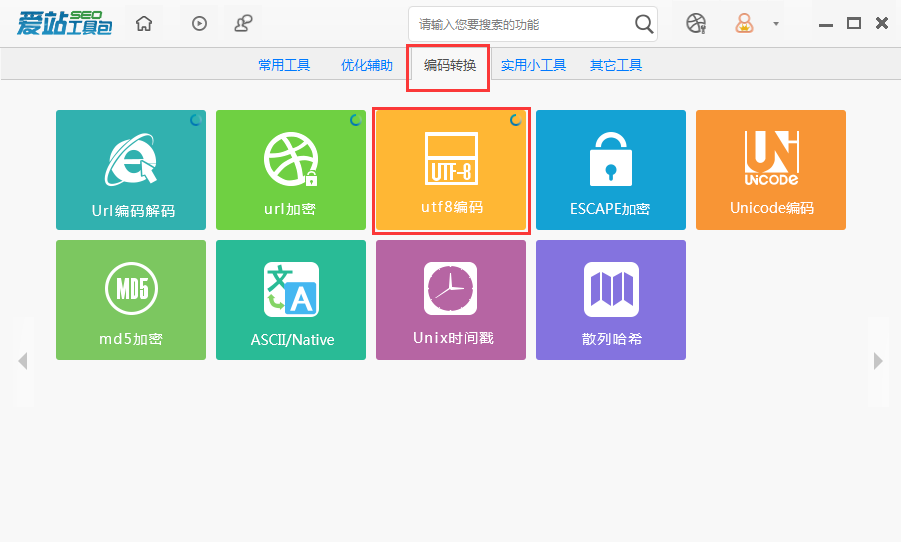

爱站SEO工具包UTF8编码功能如何使用?UTF8编码功能介绍

2023-02-05

-

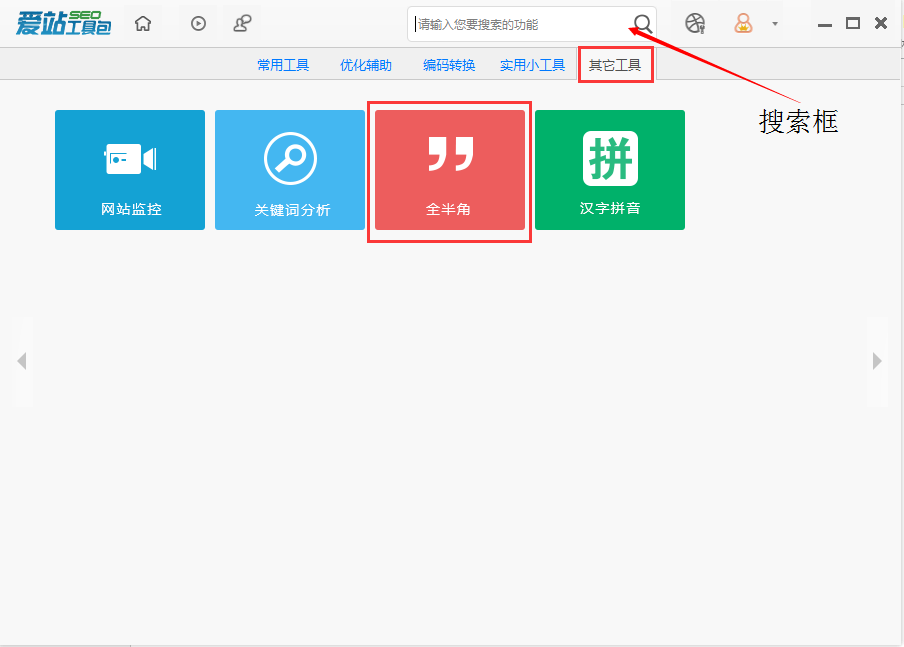

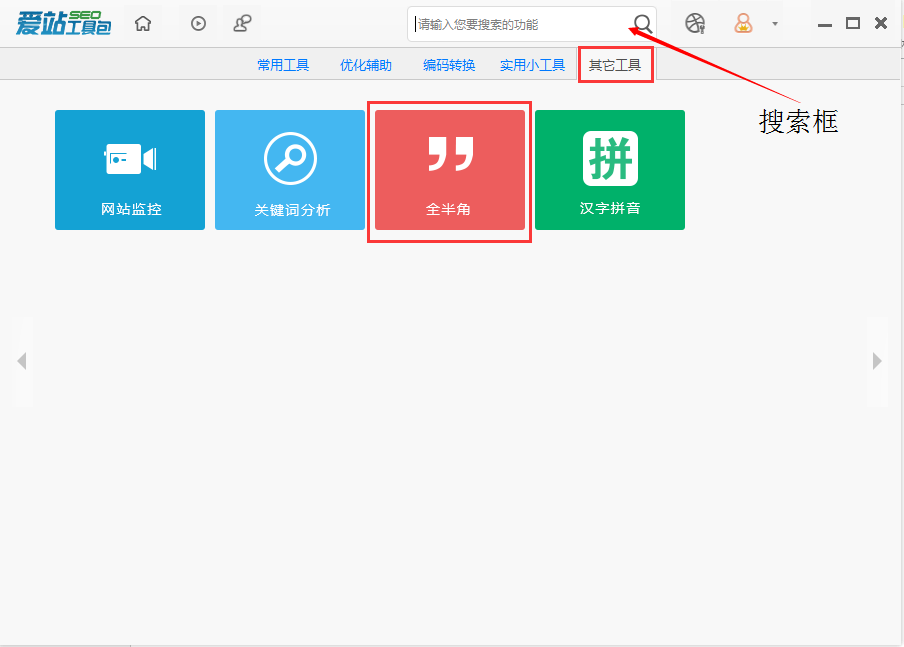

爱站SEO工具包如何使用全半角?全半角切换的操作流程

2023-03-20

-

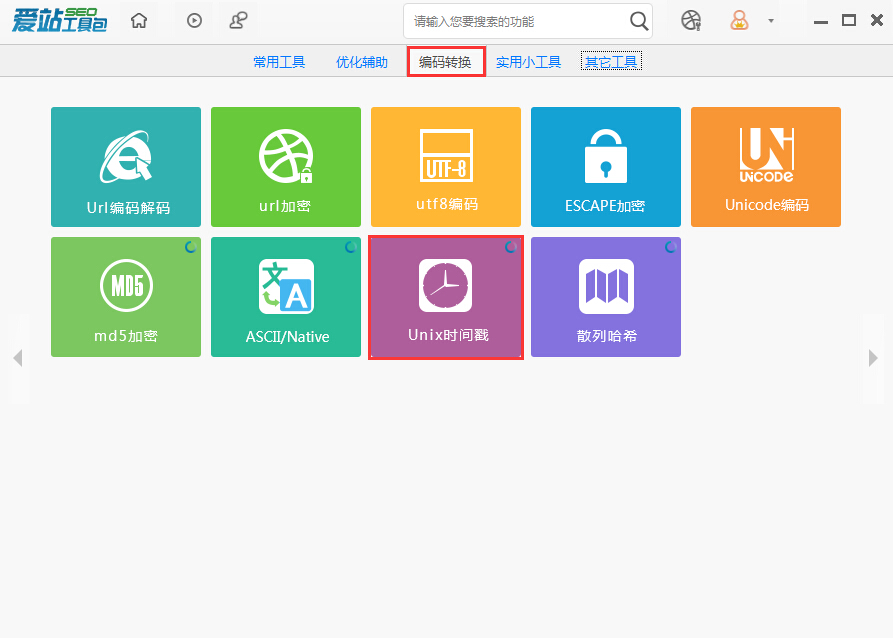

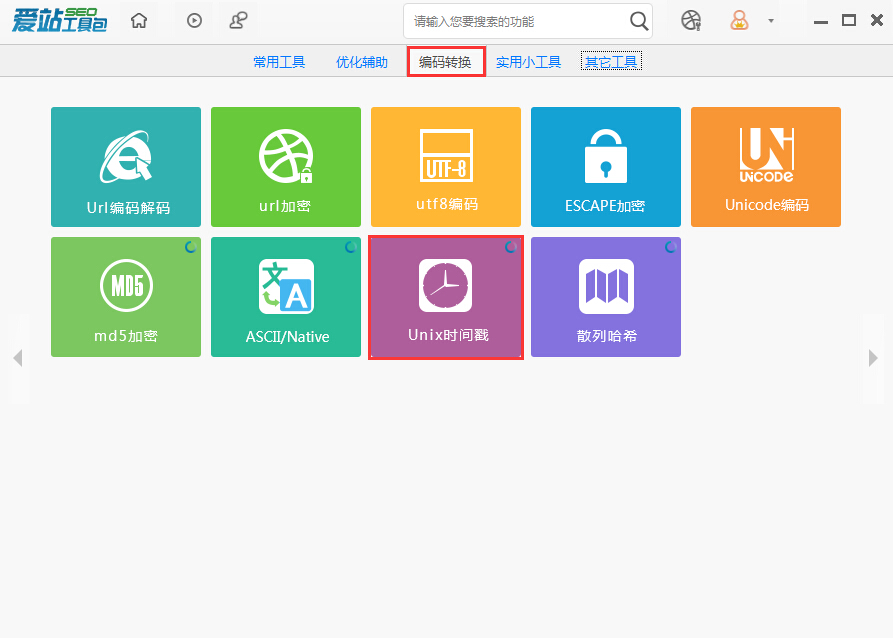

爱站SEO工具包Unix时间戳工具怎么使用?Unix时间戳介绍

2023-03-20

-

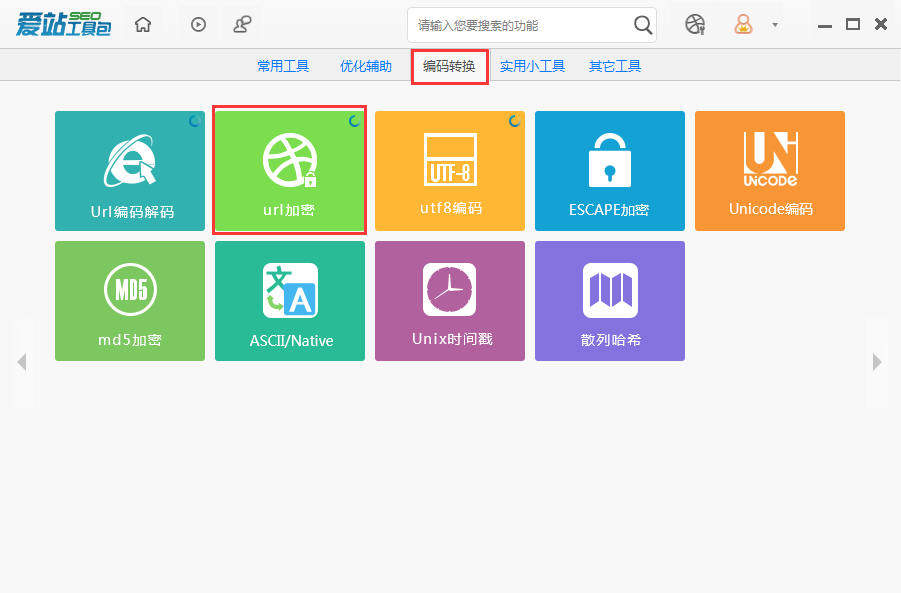

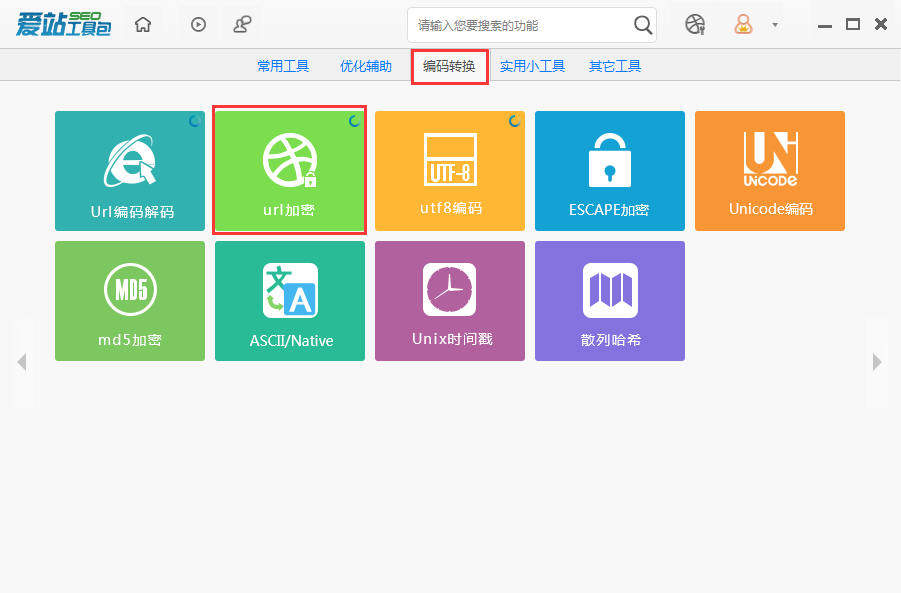

爱站SEO工具包怎么进行URL加密?URL加密的图文教程

2023-02-13

-

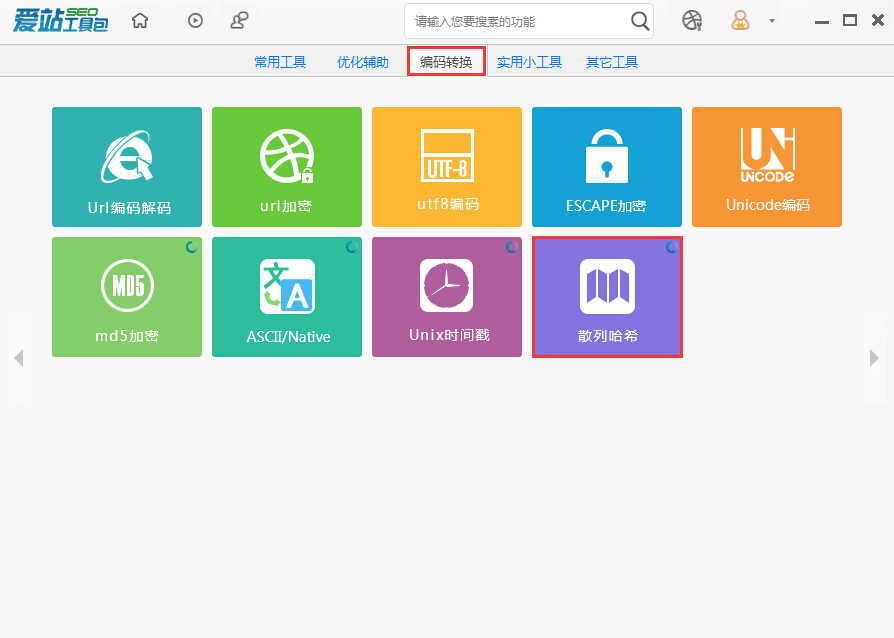

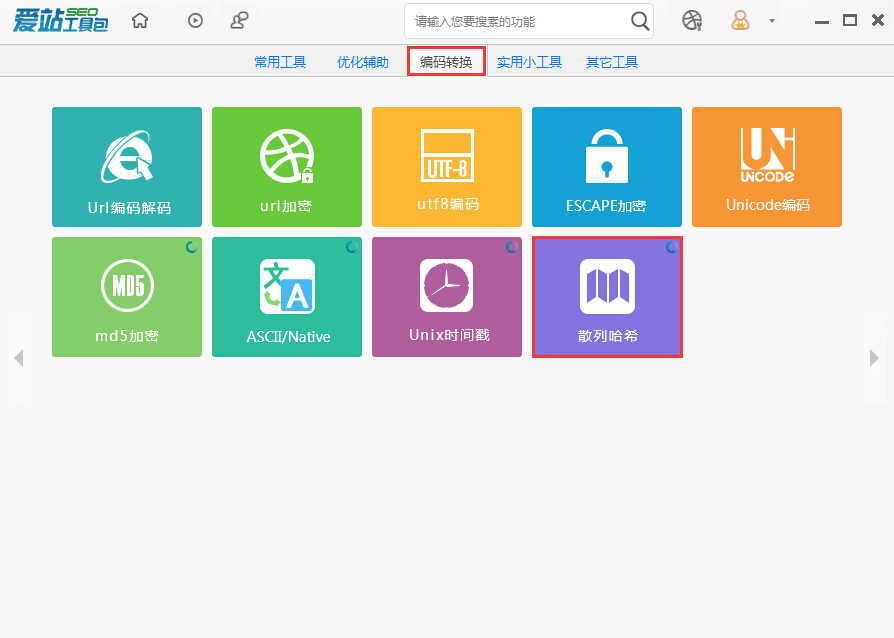

在爱站SEO工具包中怎么使用散列哈希?Hash的使用介绍

2023-02-16

-

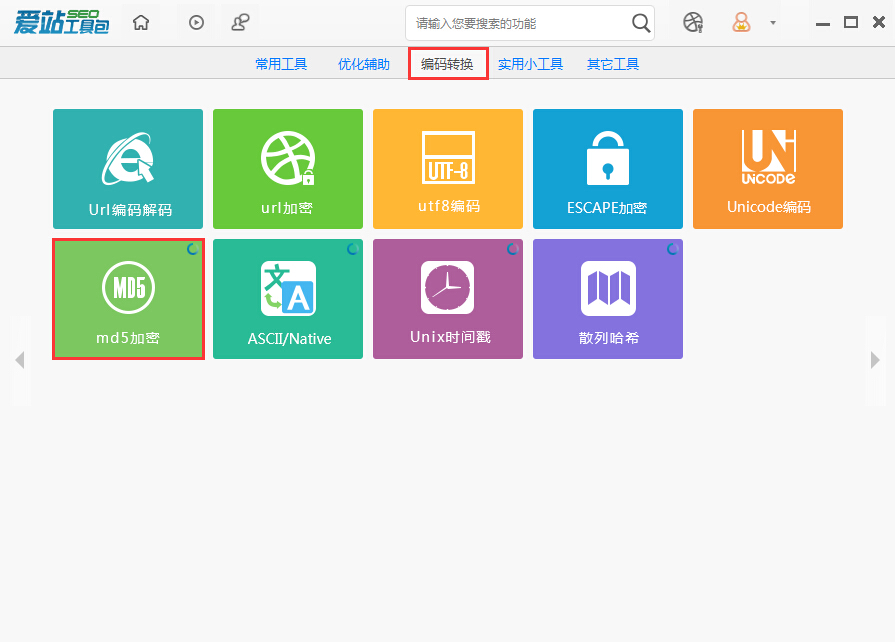

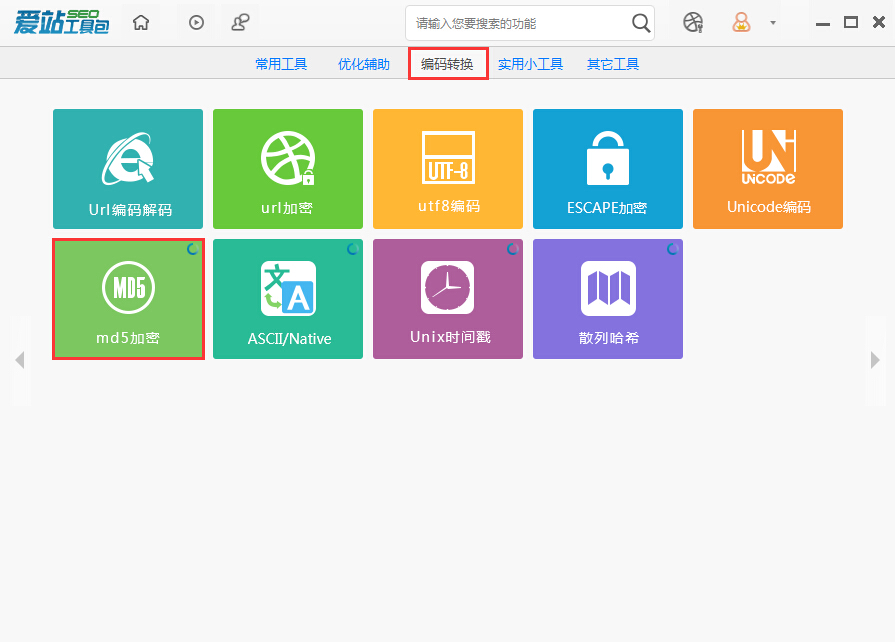

爱站SEO工具包MD5加密功能有哪些作用?MD5加密功能的使用步骤

2023-02-16

-

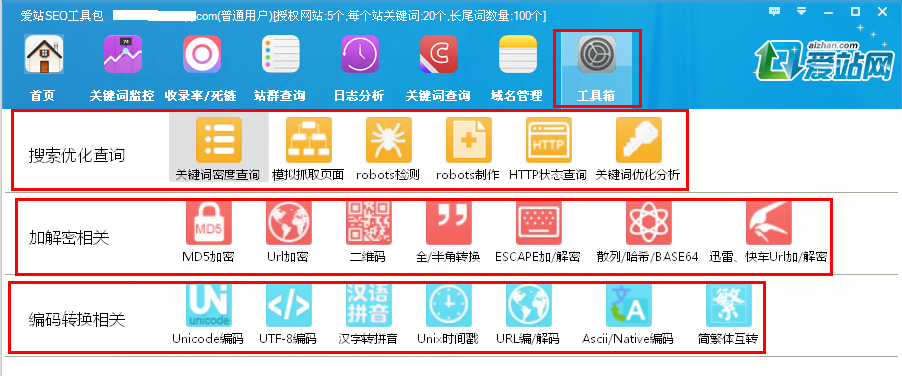

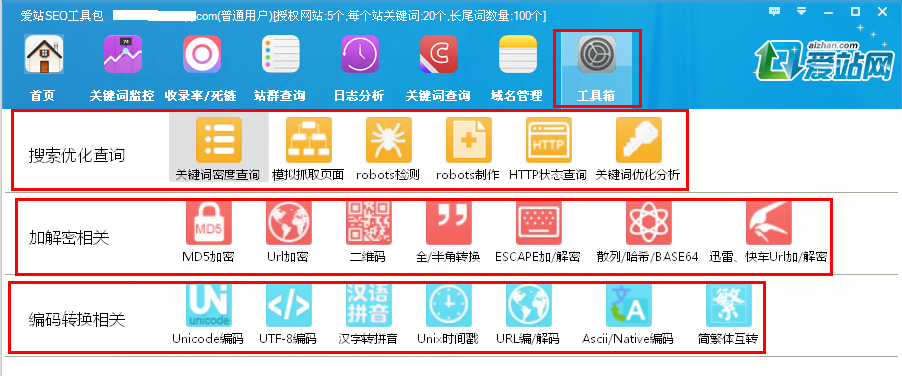

爱站SEO工具包怎么使用工具箱?工具箱的使用步骤一览

2023-02-10

相关软件

更多CopyRight©2001年-2024年 浙ICP备2024085849号-3

ai7手游帮 All Rights Reserved

意见反馈